딥시크 V3.2, 추론 능력서 빅테크 모델 위협…

'스페셜' 버전은 IMO 금메달급 성능 입증

중국의 AI 연구소 딥시크(DeepSeek)가 최신 오픈소스 언어 모델인 '딥시크-V3.2(DeepSeek-V3.2)'를 공개하며 글로벌 AI 시장에 큰 파장을 일으키고 있다. 이번 모델은 오픈AI의 'GPT-5' 및 구글의 '제미나이 3 프로(Gemini 3 Pro)'와 대등한 성능을 보이면서도 오픈소스로 공개되어 주목받고 있다.

1일(현지시간) IT 전문 매체 더디코더(The Decoder) 등에 따르면, 딥시크는 자체 기술 보고서를 통해 V3.2 모델이 주요 벤치마크와 추론 작업에서 상용 최상위 모델들과 어깨를 나란히 했다고 밝혔다.

특히 주목할 만한 성과는 수학과 코딩 분야다. 딥시크가 공개한 실험적 변형 모델인 '스페셜(Speciale)'은 2025년 국제수학올림피아드(IMO)에서 금메달 수준의 성적을 기록했으며, 국제정보올림피아드(IOI) 10위, 국제대학생프로그래밍경시대회(ICPC) 월드 파이널에서 2위를 차지하는 기염을 토했다.

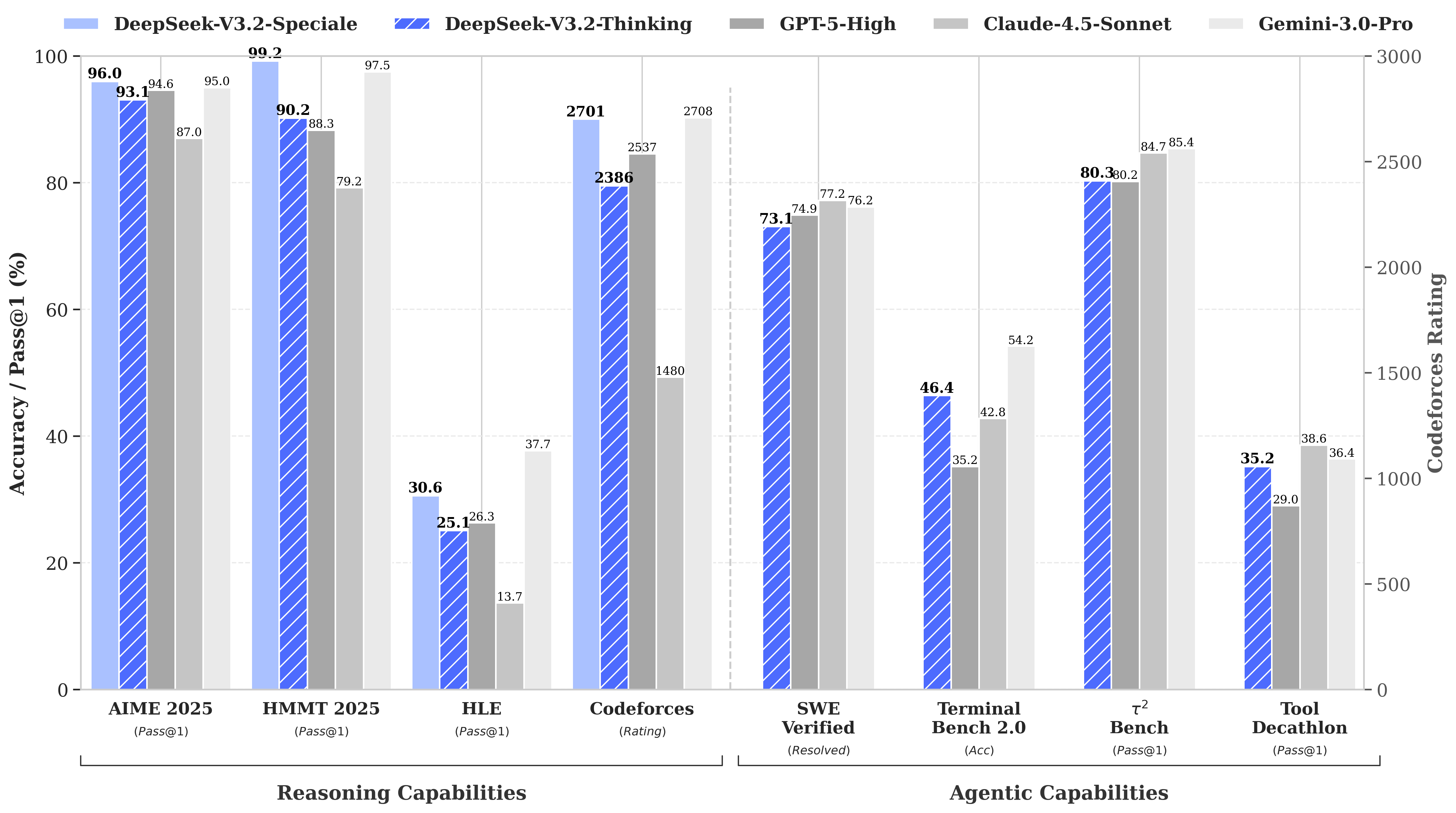

딥시크-V3.2는 구체적인 벤치마크 점수에서도 경쟁력을 입증했다.

- 수학(AIME 2025): 93.1%를 기록하며 GPT-5(High 버전, 94.6%)를 턱밑까지 추격했다. (1위는 구글 제미나이 3 프로, 95.0%)

- 코딩(LiveCodeBench): 83.3%를 달성해 GPT-5(84.5%)와 근소한 차이를 보였다.

- 소프트웨어 개발(SWE Multilingual): 실제 깃허브(GitHub) 이슈 해결 능력을 평가하는 테스트에서 70.2%의 해결률을 기록, GPT-5(55.3%)를 큰 폭으로 따돌렸다.

이번 V3.2 모델의 핵심 기술은 '딥시크 희소 어텐션(DeepSeek Sparse Attention, DSA)'이다. 기존 모델들이 긴 대화 맥락을 처리할 때 모든 이전 토큰을 재확인하여 연산 비용이 높았던 반면, DSA는 인덱싱 시스템을 통해 중요한 텍스트 기록만을 선별적으로 처리한다. 이를 통해 긴 입력값 처리 속도를 높이고 컴퓨팅 비용을 절감했다는 설명이다.

또한 딥시크는 모델의 '사후 학습(Post-training)' 단계에 막대한 투자를 단행했다. 전체 훈련 비용의 10% 이상을 강화 학습과 정렬(Alignment)에 투입했으며, 수학·프로그래밍·논리 등 특화된 모델을 먼저 구축하여 고품질의 훈련 데이터를 생성하는 전략을 사용했다.

다만 한계점도 명확히 했다. 딥시크 측은 지식의 범위(Knowledge Breadth)나 토큰 효율성 면에서는 여전히 상용 프런티어 모델에 뒤처져 있음을 인정했다. 실제로 '스페셜' 모델의 경우 추론 과정에서 구글 제미나이보다 3배 이상 많은 토큰을 소모하는 등 비용 효율성 문제가 있어, 정식 출시 버전에서는 토큰 제한을 더 엄격하게 적용했다.

딥시크-V3.2는 현재 아파치 2.0(Apache 2.0) 라이선스로 허깅페이스(Hugging Face) 등을 통해 즉시 사용할 수 있다. 업계 관계자는 "오픈소스 진영에서 GPT-5급 성능을 구현했다는 것은 AI 개발의 민주화 측면에서 큰 사건"이라며 "특히 자율 에이전트(Autonomous Agent) 개발 비용을 획기적으로 낮출 수 있는 대안이 될 것"이라고 전망했다.

'IT' 카테고리의 다른 글

| '노트북도 식별' 아리랑 7호 발사 성공…우주강국 도약 (0) | 2025.12.02 |

|---|---|

| 앤스로픽, '최고 지능' 클로드 오퍼스 4.5 출시 (0) | 2025.12.02 |

| 알리바바, 2시간짜리 영상 꿰뚫는 AI ‘Qwen3-VL’ 공개… “GPT-5·제미나이 넘었다” (0) | 2025.11.30 |

| 텐센트, 소비자용 GPU서 돌아가는 ‘훈위안비디오 1.5’ 오픈소스 공개 (0) | 2025.11.26 |

| 구글 TPU, 엔비디아 독점 흔드나 (0) | 2025.11.26 |