하이브리드 토크나이저 채택... 기존 모델의 '이해·생성 성능 상충' 문제 완화

300M에서 30B까지 확장 가능... 벤치마크서 통합 모델 중 최고 수준 기록

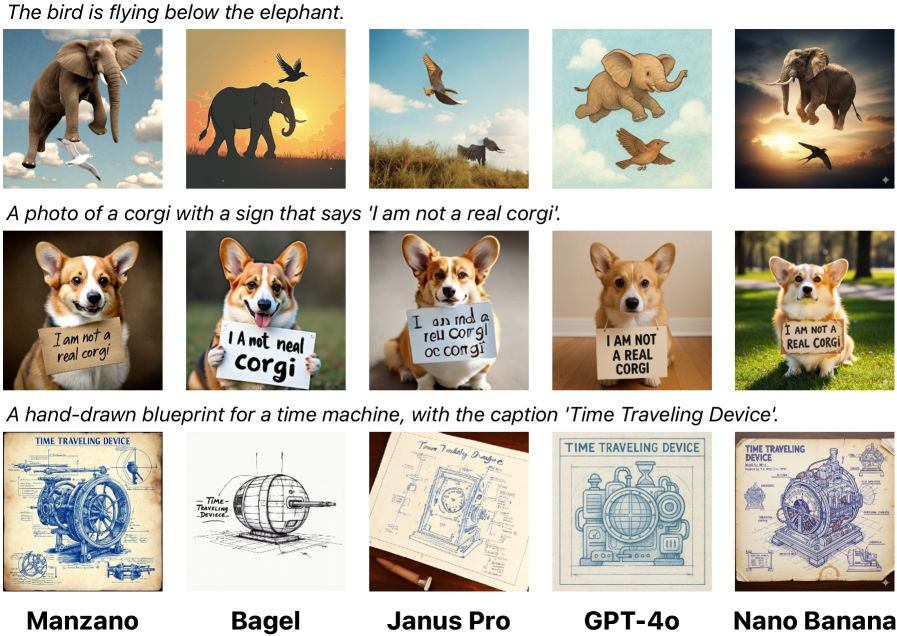

애플 연구팀이 이미지 이해와 생성을 하나의 모델에서 모두 수행하는 통합 멀티모달 대규모 언어 모델(LLM)인 '만사노(Manzano)'를 공개했다. 이 모델은 기존 통합 모델들이 양쪽 기능 중 하나에서 성능 저하를 겪는 문제를 해소하기 위해 '하이브리드 비전 토크나이저'라는 새로운 구조를 도입한 것이 특징이다.

최근 인공지능(AI) 분야에서는 텍스트뿐만 아니라 이미지, 음성 등 다양한 형태의 데이터를 처리하고 생성하는 멀티모달(Multimodal) AI 모델 개발이 활발하다. 그러나 이미지를 텍스트로 이해하는(Understanding) 과정과, 텍스트를 이미지로 변환해 생성하는(Generation) 과정에서 필요한 내부 표현 방식이 달라, 하나의 통합 모델로 두 기능을 모두 최고 수준으로 구현하는 데는 한계가 있었다. 연구팀은 이 문제를 '이해 및 생성 성능 간의 상충(trade-off)'이라고 지적해 왔다.

애플 연구팀이 아카이브(arXiv)에 발표한 논문에 따르면, 만사노 모델은 이름('Manzano'는 스페인어로 '사과나무'를 의미)처럼 애플의 자체 AI 연구 성과를 담고 있다.

핵심 기술은 하이브리드 비전 토크나이저(Hybrid Vision Tokenizer)다. 이는 하나의 공유된 비전 인코더(Vision Encoder)를 사용해 이미지 이해를 위한 연속적 임베딩(Continuous Embeddings)과 이미지 생성을 위한 이산적 토큰(Discrete Tokens)을 동시에 출력한다. 이처럼 두 종류의 표현을 공통된 의미 공간에서 생성함으로써, 기존 모델에서 발생하던 작업 간의 충돌을 최소화했다는 설명이다.

만사노는 ▲하이브리드 토크나이저 ▲통합 언어 모델(LLM) ▲보조 확산 디코더(Diffusion Decoder)의 3단계 아키텍처를 갖는다. 통합 LLM은 300M(3억 개)부터 30B(300억 개) 파라미터까지 확장 가능하며, 텍스트와 이미지 토큰을 자동 회귀 방식으로 예측해 상위 수준의 의미론적 정보를 처리하고, 보조 디코더가 이를 픽셀로 변환하는 역할을 수행한다.

애플 자체 테스트 결과, 만사노는 통합 멀티모달 모델 벤치마크에서 최고 수준의 결과를 기록했으며, 특히 텍스트 정보가 많은 벤치마크에서 강점을 보였다. 모델 크기를 확장할수록 성능이 꾸준히 향상되는 스케일링(Scaling) 효과도 입증했다.

애플은 만사노 모델을 통해 향후 자사의 AI 플랫폼인 '애플 인텔리전스(Apple Intelligence)'의 핵심 기능을 대폭 강화할 것으로 전망된다. 통합된 모델은 리소스 효율성을 높여 기기 내(온디바이스) AI 구현에 유리하며, 사용자에게 더욱 정교하고 다양한 멀티모달 경험을 제공할 수 있다.

출처 및 상세 정보 링크

- 연구 논문: Li et al. (2025). MANZANO: A Simple and Scalable Unified Multimodal Model with a Hybrid Vision Tokenizer. arXiv:2509.16197

- 원문 기사: Apple introduces Manzano, a model for both image understanding and generation (The Decoder)

'IT' 카테고리의 다른 글

| OpenAI, 챗GPT를 '능동적 비서'로 전환한다 (0) | 2025.09.29 |

|---|---|

| 마이크로소프트, 최대 90분 길이 팟캐스트 제작 가능한 AI 모델 '바이브보이스' 공개 (1) | 2025.09.28 |

| 메타, AI 생성 동영상 피드 '바이브스' 출시...광고에 구글 제미나이 활용도 검토 (0) | 2025.09.27 |

| 삼성전자, AI 업무 생산성 측정 지표 ‘트루벤치’ 개발 (2) | 2025.09.26 |

| 영국 AI 스타트업 Nscale, 11억 달러 투자 유치...유럽 역대 최대 시리즈 B (0) | 2025.09.25 |