반응형

목차

Ollama는 로컬 환경에서 대규모 언어 모델(LLM)을 실행할 수 있게 해주는 오픈 소스 도구입니다. Meta의 Llama2, Llama3, Mistral 등 다양한 모델을 간단히 다운로드하고 바로 테스트해볼 수 있으며, 별도의 상용 API나 클라우드 서비스 없이도 AI 모델을 이용할 수 있다는 장점이 있습니다.

1. Ollama란?

- 로컬 환경 LLM 실행

Ollama를 사용하면 인터넷 연결이 없거나 제한된 환경에서도 로컬 컴퓨터에서 LLM 모델을 활용할 수 있습니다. - 간단한 인터페이스

사용법이 Docker와 유사해pull,run,rm등의 명령어로 모델을 다운로드·실행·삭제할 수 있어 매우 간편합니다.

반응형

2. Ollama 설치하기

2.1 Windows

- Ollama 공식 웹사이트에서 Windows용 설치 파일(

.exe)을 다운로드합니다. - 설치 파일을 실행하고 안내되는 지침에 따라 설치 과정을 완료합니다.

- 설치가 완료되면 작업 표시줄 등에 Ollama 아이콘이 표시되어 현재 동작 중임을 확인할 수 있습니다.

2.2 macOS

- Ollama 공식 웹사이트에서 Mac용 설치 파일을 다운로드합니다.

- 다운로드된

.zip혹은.dmg파일을 열고,Ollama.app을 응용 프로그램 폴더로 드래그 앤 드롭합니다. Ollama.app을 실행하여 설치를 마무리합니다.

2.3 Linux

- 터미널을 열고 아래 명령어를 입력합니다:

curl -fsSL https://ollama.com/install.sh | sh - 설치가 완료되면

ollama명령어로 Ollama를 사용할 수 있습니다.

3. Ollama 명령어 및 기본 사용법

설치가 끝났다면, 터미널이나 명령 프롬프트에서 다음 명령어들을 사용할 수 있습니다

서버 실행:Ollama 서버(프로세스)를 직접 실행하고 싶을 때 사용합니다.

ollama serve

모델 다운로드:원하는 모델을 로컬에 내려받습니다.

ollama pull llama3ollama run [모델명]

모델 목록 확인:로컬 환경에 다운로드된 모델들의 목록을 확인할 수 있습니다.

ollama list

모델 삭제:특정 모델을 로컬 저장소에서 삭제합니다.

ollama rm [모델명]예시 시나리오

Llama2 모델 받기

ollama pull llama3

실행해보기

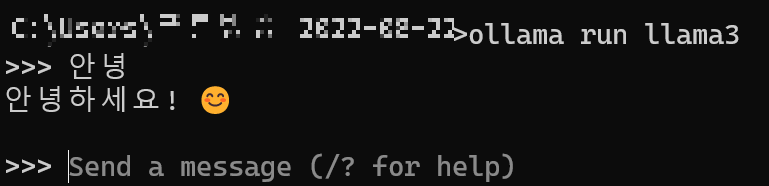

ollama run llama3 "안녕하세요, 머신러닝 개념을 알려주세요."

모델 목록 조회

ollama list

모델 제거

ollama rm llama34. 마무리

지금까지 Ollama를 다운로드하고 사용하는 기초 과정을 살펴봤습니다. 로컬 환경에서 LLM을 실행하면 추가 API 비용 없이 자유롭게 모델을 실험할 수 있다는 장점이 있습니다. Ollama를 통해 다양한 공개 모델(Llama2, Mistral, Gemma 등)을 빠르게 시험해보시기 바랍니다.

반응형

'IT' 카테고리의 다른 글

| ChatGPT, 이제 알림과 반복 작업을 예약할 수 있다! (0) | 2025.01.15 |

|---|---|

| Mistral, 새로운 코드 생성 모델 Codestral 25.01 출시! 🚀 (0) | 2025.01.14 |

| 카카오, 팬덤 플랫폼 시장 진출: '베리즈' 출시에 주목 (0) | 2025.01.08 |

| 오픈AI의 영리법인 전환: 논란과 전망 (1) | 2025.01.08 |

| 딥시크-V3 (DeepSeek-V3): 오픈소스 AI의 새로운 기준 (0) | 2025.01.08 |