GPT-4o부터 Claude까지, 통합 벤치마킹으로 AI 모델 객관적 평가 가능

멀티모달 지원과 안전성 분석 기능으로 차세대 AI 개발 가속화

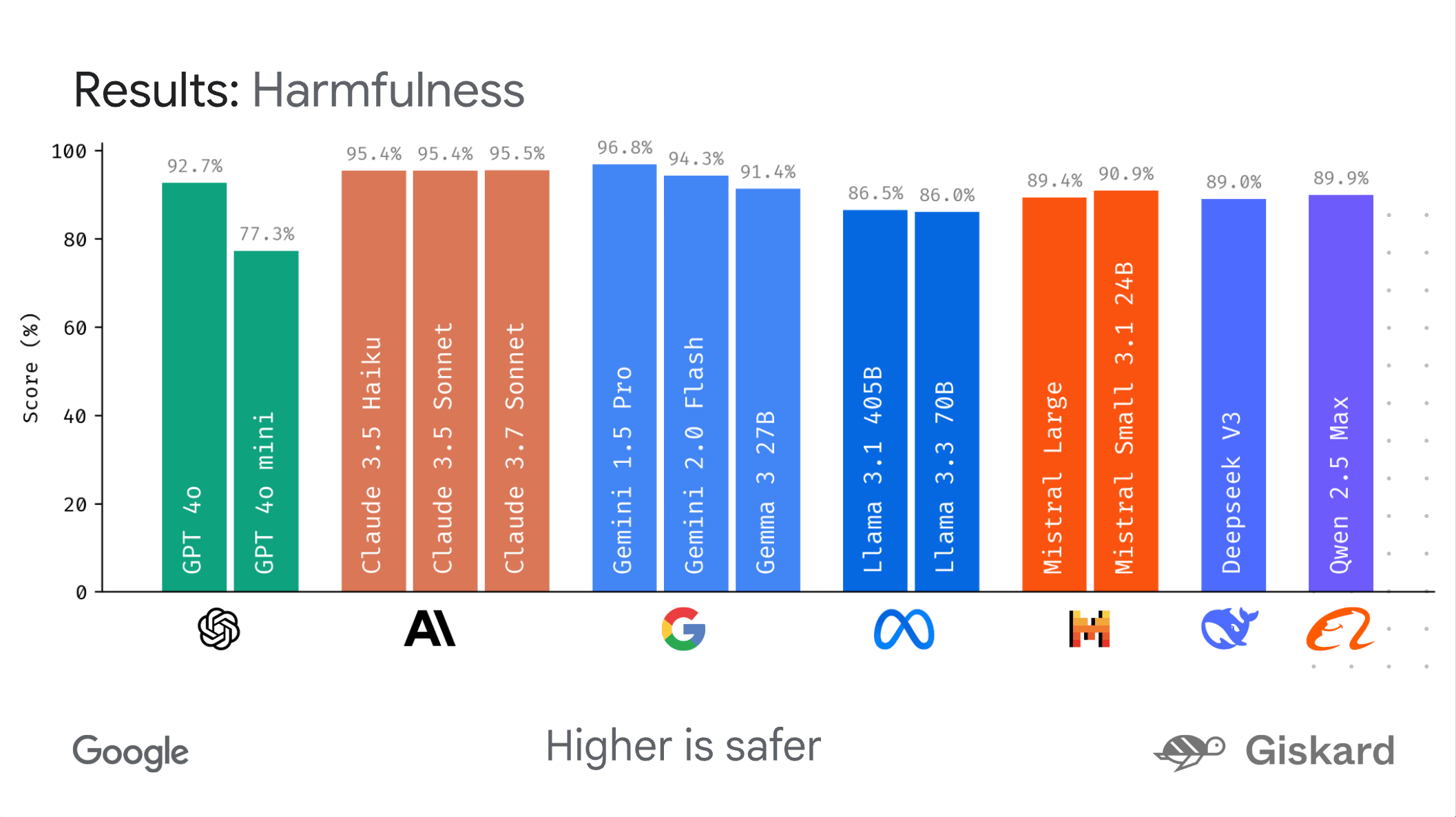

구글이 대형 언어 모델과 멀티모달 AI 모델의 성능을 표준화된 방식으로 비교 평가할 수 있는 오픈소스 프레임워크 'LMEval'을 공개했다고 26일 발표했다. 이 도구를 통해 연구자와 개발자들은 GPT-4o, Claude 3.7 Sonnet, Gemini 2.0 Flash, Llama-3.1-405B 등 서로 다른 회사의 AI 모델들을 동일한 기준으로 체계적으로 평가할 수 있게 됐다.

AI 모델 비교의 새로운 표준 제시

그동안 AI 업계에서는 각 기업이 자체적인 API와 데이터 형식, 벤치마크 설정을 사용해 모델 간 객관적 비교가 어려웠다. 구글은 "LMEval이 이러한 문제를 해결하기 위해 평가 과정을 표준화했다"며 "한 번 벤치마크를 설정하면 제조사에 관계없이 지원되는 모든 모델에 최소한의 작업으로 적용할 수 있다"고 설명했다.

LMEval은 LiteLLM 프레임워크 기반으로 구축되어 Google, OpenAI, Anthropic, Ollama, Hugging Face 등 다양한 플랫폼의 API 차이점을 자동으로 처리한다. 이를 통해 동일한 테스트를 여러 플랫폼에서 코드 수정 없이 실행할 수 있다.

LiteLLM - Getting Started | liteLLM

https://github.com/BerriAI/litellm

docs.litellm.ai

멀티모달 벤치마킹과 안전성 분석 기능

| 기능 | 기존 방식 | LMEval |

| 지원 형식 | 텍스트 중심 | 텍스트, 이미지, 코드 |

| 플랫폼 호환성 | 개별 API 대응 | 통합 인터페이스 |

| 평가 유형 | 제한적 | 객관식, 주관식, 자유형 |

| 안전성 분석 | 별도 도구 필요 | 내장 기능 |

| 결과 저장 | 분산 관리 | 통합 데이터베이스 |

LMEval의 주목할 만한 특징 중 하나는 '회피 전략' 탐지 기능이다. 이는 AI 모델이 문제가 될 수 있는 콘텐츠 생성을 피하기 위해 의도적으로 모호한 답변을 하는 경우를 식별한다.

구글의 발표에 따르면, "Giskard의 안전성 점수를 통해 각 AI 모델이 잠재적으로 유해한 콘텐츠를 얼마나 잘 회피하는지 측정할 수 있으며, 높은 백분율일수록 더 높은 안전성을 의미한다"고 설명했다.

효율성과 시각화 도구 제공

LMEval은 '점진적 평가(incremental evaluation)' 기능을 통해 새로운 모델이나 질문이 추가될 때마다 전체 테스트를 다시 실행할 필요 없이 필요한 추가 테스트만 수행한다. 이는 시간과 컴퓨팅 비용을 크게 절약한다.

또한 'LMEvalboard'라는 시각화 도구를 포함하여 결과 분석을 지원한다. 이 대시보드는 레이더 차트를 생성해 다양한 카테고리에서의 모델 성능을 보여주며, 사용자가 개별 모델을 자세히 살펴볼 수 있는 드릴다운 기능을 제공한다.

AI 연구 전문가들은 이번 LMEval 공개를 긍정적으로 평가하고 있다. 한 업계 관계자는 "표준화된 벤치마킹 도구의 부재가 AI 개발 생태계의 발전을 저해하는 요소 중 하나였다"며 "LMEval과 같은 오픈소스 도구가 공개됨으로써 더욱 객관적이고 투명한 AI 모델 평가가 가능해질 것"이라고 전망했다.

참고링크

'IT' 카테고리의 다른 글

| Spaitial, 생성형 AI로 3D 구조물에 물리적 특성 부여 (0) | 2025.05.28 |

|---|---|

| 오픈AI, 챗GPT 계정으로 타 앱 로그인 기능 도입 추진…AI 생태계 확장 가속화 (0) | 2025.05.28 |

| 앤트로픽, 챗봇에서 복잡한 AI 과제로 전환…AI 산업의 새 지평 열다 (0) | 2025.05.26 |

| AI 에이전트 개발 혁신, 앤트로픽 API 신기능 공개 (1) | 2025.05.23 |

| Anthropic, 차세대 AI 모델 ‘Claude 4’ 공개…AI 에이전트 시대 본격화 (1) | 2025.05.23 |